Un réseau social sur Internet c’est avant tout un moyen de garder le lien entre les personnes et d’échanger. C’est aussi un moyen pour développer des contacts et toucher un public plus large, c’est cela qu’exploitent ceux qui ont besoin de communiquer. C’est le cas notamment des services publics et bien évidemment des responsables politiques et des marques. Sur les réseaux publics commerciaux ce sont ces dernières qui financent classiquement le fonctionnement de ces réseaux, notamment par le biais de la publicité.

Évidemment la communication publique ne va pas sans dérives, qu’il s’agisse de diffusion de contenus illégaux ou menant à des contenus ou activités illégales (comme des liens vers des sites de hameçonnage), ou sans qu’elles soient explicitement illégales, des pratiques abusives qui peuvent nuire à la qualité des échanges, créer des tensions ou propager des informations erronées – volontairement ou non – ou pire, manipulatrices.

D’autres dérives sont nées des abus par les plateformes elles-mêmes dans leur exploitation des données des utilisateurs, directement ou indirectement – notamment au travers des capacités de ciblage qu’ils ont pu offrir aux annonceurs – et qui ont par exemple pu être utilisées pour tenter de manipuler l’opinion comme l’a révélé le scandale Cambridge Analytica (à ce sujet je recommande la lecture du livre Mindf*ck: Cambridge Analytica and the Plot to Break America par Christopher Wylie, un des lanceurs d’alerte les mieux placés pour en parler).

Un certain nombre d’événements récents ont beaucoup fait évoluer le paysage des réseaux sociaux

- le développement des réseaux sociaux à consommation aléatoire tels que Tiktok ou Snapchat (leurs stratégies ont depuis été reprises par les autres réseaux commerciaux qui propulsent de plus en plus de contenus addictifs – courts et créant de l’engagement – dans les flux de lecture de leurs utilisateurs);

- le rachat en 2022 de Twitter par Elon Musk (il a depuis renommé la société et son produit « X ») – sans compter la création quelques années auparavant de réseaux sociaux alternatifs qui voulaient répondre à la trop grande modération sur les plateformes telles que Twitter ou Facebook comme Gab, Parler ou Truth.social.

- l’arrivée de nouveaux réseaux sociaux commerciaux reprenant le modèle de micro-blogging popularisé par Twitter: BlueSky et Threads (de la société Meta comme Facebook/Instagram/Whatsapp), mais cherchant à développer des modèles décentralisés, BlueSky avec son propre protocole (ATProto) et Threads en embrassant le protocole ActivityPub du fédivers (dont j’ai déjà parlé ici).

et des évolutions dans la régulation avec l’avènement du DSA et du DMA en Europe qui non seulement harmonisent la régulation des plateformes mais coordonnent l’action des différents pays européens dans cette régulation. La France était déjà bien engagée dans cette régulation depuis 2004 avec la Loi pour la confiance dans l’économie numérique (LCEN). On peut aussi citer parmi les événements marquants l’arrestation de Pavel Durov en France au mois d’août 2024 pour cause d’un fort manque de coopération avec les autorités judiciaires de nombreux pays – le réseau Telegram est une messagerie instantanée mais aussi beaucoup un réseau social au travers de ses fonctionnalités de groupes.

Il semble que nous ayons atteint les limites de l’auto-régulation

Pendant de nombreuses années, la régulation des médias sociaux c’est construite autour des concepts d’auto-régulation et de co-régulation. Les industriels en particulier ont défendu le premier modèle et ont beaucoup travaillé les concepts de « standards de communauté » (on pourra à ce sujet se référer à l’initiative Open Terms Archive qui en documente l’évolution) qui paraissaient nécessaires en particulier dans le pays de la liberté d’expression extrême qu’est les Etats-Unis, reproduisant les règles qui se sont mises en place petit à petit dans l’espace public, au sein des entreprises et dans les médias traditionnels en particulier.

Dans un contexte international, cette vision s’est heurtée à celle plus policée de l’Europe qui préfère souvent expliciter dans la loi les interdits, pour accompagner en particulier la protection des minorités ou des personnes victimes de discrimination – tout en retenant au passage les leçons de l’Histoire et réprimant comme en France l’apologie des crimes de guerre et contre l’Humanité. Le dialogue de co-régulation établi en Europe (entre les industriels, les Etats, mais aussi des représentants de la société civile) a permis d’aboutir à la conclusion qu’une législation à l’échelle du continent était nécessaire pour avoir un cadre commun de traitement, et c’est ce à quoi répond le DSA notamment. Au-delà de l’Europe, on peut aussi citer l’Appel de Christchurch qui vise à une échelle plus globale à prévoir des engagements forts contre l’apologie du terrorisme, sans prendre une forme légale contraignante à ce stade.

Ce texte impose notamment des obligations de transparence des plateformes sur leurs pratiques de modération des contenus, tout en leur imposant évidemment de répondre aux sollicitations du public et des autorités quant aux contenus illégaux – et non pas simplement interdits ou modérés dans les conditions générales d’utilisation de ces plateformes.

Mais très récemment, le ménage fait dans les équipes de modération de Twitter par Elon Musk, puis les annonces ces quinze derniers jours par Mark Zuckerberg laissent augurer un paysage beaucoup moins favorable au dialogue sur la régulation.

L’évolution de la situation chez Twitter a été beaucoup commentée ces deux dernières années et force est de constater que son trafic a fortement baissé. Mais analysons les points clés des déclarations du patron de Meta:

- se débarrasser (en anglais, il utilise le terme « to get rid of ») des accords avec des services de fact-checking, et les remplacer par des notes de communauté dans le même style que sur X, d’abord aux USA puis dans le reste du monde.

- déplacer la gouvernance de la régulation des contenus de la Californie vers le Texas, qui serait selon lui un Etat moins biaisé;

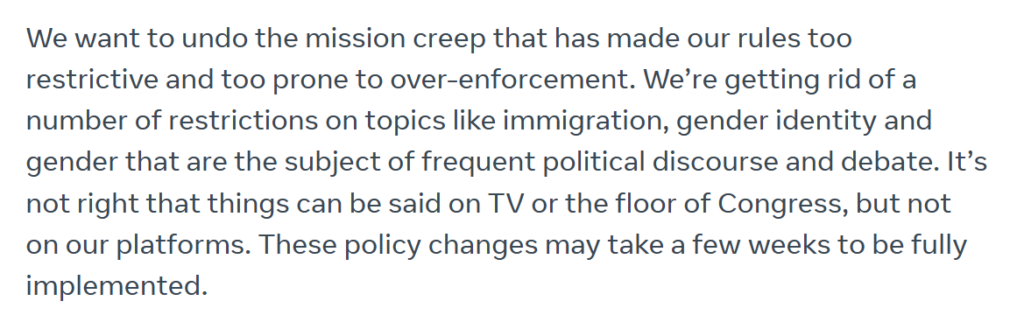

- la simplification des règles de modération (en les limitant strictement à ce qui est illégal), l’assouplissement des modérations automatiques et l’introduction de nouvelles dispositions de gestion des suppressions de compte (la déclaration complète parle de reconnaissance faciale notamment)

Au passage, le texte reproduit sur le site Web ne reprend pas l’intégralité des déclarations faites dans la vidéo. Notamment le texte suivant:

Europe has an ever-increasing number of laws institutionalizing censorship and making it difficult to build anything innovative there.

Il fait ici référence aux textes évoqués plus haut. La Commission européenne a répondu assez fermement à cette déclaration, rappelant en particulier que ces textes ne font que réclamer la transparence et l’efficacité sur la régulation des contenus déjà illégaux en Europe et ne crée aucun type de nouvelle interdiction de contenu. Au passage, Mark Zuckerberg se contredit puisqu’il déclare vouloir limiter la modération aux contenus illégaux et quelques minutes plus tard critique les textes européens qui justement demandent de modérer ces contenus illégaux…

Un autre problème semble devoir être soulevé, si on regarde dans le détail, à savoir que les nouvelles règles ne seraient d’abord appliquées qu’aux Etats-Unis. En effet, Threads – le réseau concurrent à X de la société Meta – étant dorénavant interconnecté avec les milliers de serveurs du fédiverse, des contenus éventuellement illégaux seront diffusés largement au-delà du public américain.

Et cela d’autant plus que les nouvelles règles de modération ont été déjà mises en place dans la version américaine publiée par Meta et supprime de nombreuses protections contre les discours haineux.

Certaines associations de défense des libertés ont longtemps combattu les abus dans la modération mise en œuvre par les plateformes, en particulier Meta. L’Electronic frontier foundation reste très préoccupée par les dernières évolutions qui ne répondent pas aux enjeux et créent de nouveaux risques pour les personnes vulnérables.

Quel avenir pour la modération des réseaux sociaux ?

Même s’ils restent marginaux en volume, les réseaux sociaux déconcentrés sont de plus en plus répandus et le modèle a même été adopté par les grandes plateformes (Threads de Meta et en quelque sorte BlueSky nouvel entrant de taille financé par de gros investisseurs). Cette fragmentation des acteurs de toute taille va progressivement faire évoluer les réseaux sociaux vers un modèle très semblable à celui du Web en général ou du courrier électronique avec une grande variété d’acteurs responsables de l’administration des serveurs et de la modération.

Il est indispensable en particulier que les nouveaux entrants adoptent très vite des outils permettant à de petites équipes de jouer leur rôle de modérateurs dans de bonnes conditions. Il n’existe à ce jour qu’une seule initiative visant à fédérer les efforts dans ce sens, l’IFTAS. Celle-ci semble construite sur une vision américaine des enjeux, il me paraît nécessaire que les acteurs d’autres régions du monde – et donc en particulier Européens – s’investissent très vite dans ces réflexions, à la fois sur les objectifs et les outils. Renaud Chaput de l’équipe technique derrière Mastodon en parle par exemple ici.

Vous pouvez poursuivre la discussion sur @ericfreyss@mastodon.social.